La digitalización del crédito en Estados Unidos ya no es experimento. Modelos complejos, machine learning y decision engines se usan en tarjetas, préstamos personales y cada vez más en hipotecas y home equity.

Ese avance choca con un marco legal que gira en torno a ECOA, una ley que exige trato no discriminatorio y explicaciones claras cuando se niega crédito o se empeoran condiciones (las llamadas “adverse action notices”).

El CFPB ha ido mandando señales desde 2022 y 2023 sobre cómo deben explicar sus decisiones los acreedores cuando usan algoritmos. La nueva propuesta de regulación busca meter esos criterios directamente en las reglas de ECOA y su reglamento Regulation B, en lugar de depender solo de circulares interpretativas.

Qué cambia y por qué importa

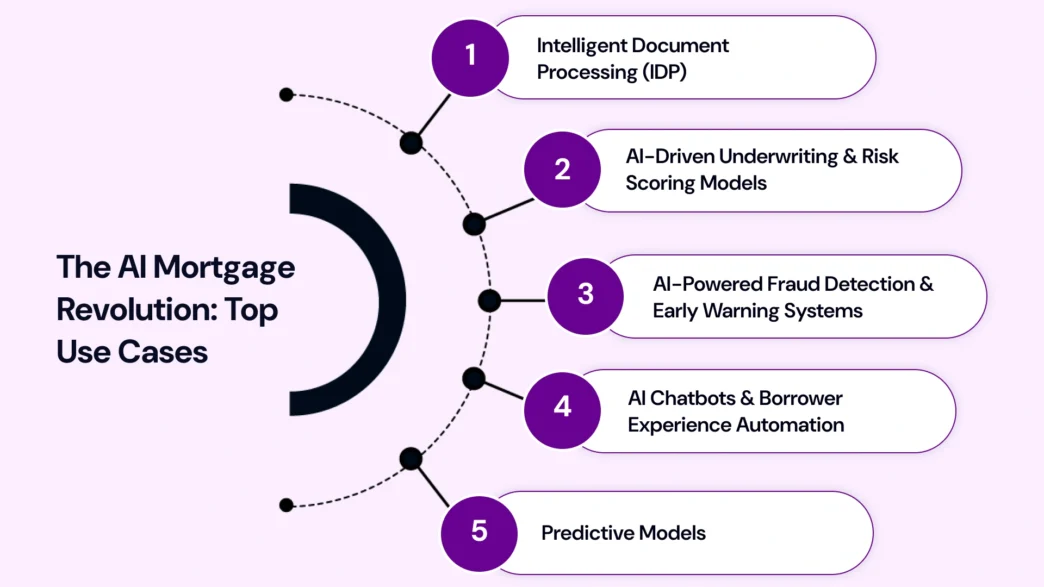

El eje de la propuesta está en tres frentes:

- Explicaciones entendibles, incluso con IA No basta decir “modelo interno” o “puntuación algorítmica”. Los acreedores tendrían que detallar los factores clave que llevaron a una negativa o a condiciones menos favorables, aun cuando el modelo sea complejo o de “caja negra”.

- Disparate impact bajo la lupa Se refuerza la idea de que ECOA también persigue efectos discriminatorios indirectos: modelos que, aunque no “intentan” discriminar, terminan afectando de manera desproporcionada a ciertos grupos protegidos. Eso pega de lleno a modelos entrenados con datos históricos sesgados.

- Trazabilidad y gobernanza de modelos Para cumplir, los bancos y fintechs tendrán que documentar cómo se entrena el modelo, qué variables usan, qué variables se excluyen y cómo se monitorean resultados por grupo poblacional.

El mensaje es claro: usar IA y modelos avanzados sí, pero con capacidad de explicarlos y probar que no discriminan de manera ilegal.

Implicaciones para hipotecas, fintechs y real estate

Para el ecosistema inmobiliario, lo relevante no es la teoría legal, sino la operación:

- Originadores hipotecarios y servicers Tendrán que revisar scores internos, herramientas de underwriting automatizado y cualquier decisión que impacte términos de crédito (tasa, monto, plazos). Los modelos que “aprendieron” de décadas de originación sesgada tendrán que pasar por auditorías serias de fair lending.

- Fintechs de originación y proptechs de crédito Su promesa de “onboarding en minutos” choca con la obligación de generar explicaciones claras y auditables. El reto: mantener experiencia de usuario ágil sin caer en opacidad regulatoria.

- Fondos y bancos que compran carteras El riesgo no está solo en el crédito subyacente, sino en el proceso de originación. Carteras generadas con modelos opacos pueden cargar riesgo legal y reputacional, además del riesgo crediticio.

Qué significa para el capital inmobiliario

En la práctica:

- Menos espacio para algoritmos “caja negra” en hipotecas residenciales y crédito ligado a vivienda.

- Más presupuesto para gobernanza de modelos, legal y compliance.

- Mayor presión para demostrar inclusión financiera real, no solo marketing.

Para el capital que invierte en originadores, bancos regionales o fintechs con exposición inmobiliaria, la tesis se mueve: ya no es solo quién tiene el mejor modelo, sino quién puede explicar mejor cómo decide, sin discriminar.